0%

2.3 数据预处理

本文字数: 284 阅读时长 ≈ 1 分钟

数据预处理策略和技术常见的有以下几种:

- 聚集 Aggregation

- 抽样 Sampling

- 维规约 Dimensionality reduction

- 特征子集选择 Feature subset selection

- 特征创建 Feature creation

- 离散化和二元化 Discretization and binarization

- 变量转换 Variable transformation

总之,以上技术可以归为两类:选择分析所需要的数据对象和属性以及创造/改变属性。其目标是降低数据挖掘分析的时间,花销和提高质量。后述的特征(feature)和变量(variable)都是指属性(attribute)。

2.3.1 聚集

本文字数: 657 阅读时长 ≈ 1 分钟

2.3.1 聚集

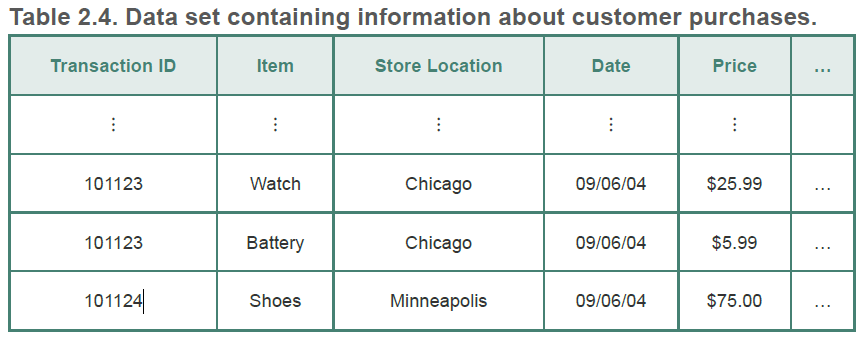

聚集(Aggregation)就是将两个或多个对象合并成单个对象。例如一个记录了不同地区的各个商店每日的交易信息,如图2.4,可以将其按照地区进行聚集。这样可以减少每日每个商店的单个交易记录。

聚集时的一些属性值需要改变。定量(Quantitative)的一些属性,例如价格可以是求总和或者平均值进行聚集。定性的属性(qualitative),例如商品名称可以忽略或汇总为一个大类,比如电视机归为家电类。

表2.4也可以看做是一个多维数组,每一个属性都是一个维。从这方面来看,聚集是一个删除属性的过程,或者是压缩特定属性不同值个数的过程。例如物品名称归为大类,时间记录从每天归为每月。这用聚集方法通常用于联机分析处理(Online Analytical Processing,OLAP)技术。

以下为使用聚集的动机。

- 数据规约导致的较小数据集可以减少内存和处理时间等的花销。也因此一些开销较大的算法的使用也成为了可能。

- 通过高层而不是底层数据视图,聚集起了范围或标度转换的作用。上面例子中的将每个商店位置聚集为地区,将每日数据归为每月,将商品归为大类等操作。

- 对象或属性群的行为通常比单个对象或属性的行为更加稳定。这反映了统计学的事实:相对于被聚集的单个对象,诸如平均值、总数等聚集量具有较小的变异性。对于总数,实际变差大于单个对象的(平均)变差,但是变差的百分比较小;对于均值,实际变差小于单个对象的(平均)变差。

聚合的缺点就是可能会丢失一些有用的细节。上例中,将每日数据聚合为每月,将无法估计每周哪天的销量最好。

2.3.2 抽样

本文字数: 866 阅读时长 ≈ 1 分钟

抽样

抽样是一种选择数据对象子集进行分析的常用方法。在数据挖掘中,抽样的目的是减小计算的成本(内存,时间等处理因素),在某些情况下使用抽样的算法可以压缩数据量,以便使用更好但开销较大的数据挖掘算法。

有效抽样的主要原理如下:

- 如果样本是由代表性的,则使用样本与使用整个数据集的效果几乎一样

- 代表性的样本和原始数据集有相同的性质。如果数据对象的均值(平均值)是感兴趣的性质,而样本具有近似于原数据集的均值,则样本就是有代表性的。

由于抽样是一个统计过程,特定样本的代表性是变化的,因此我们所能做的最好的抽样方案就是选择一个确保以很高的概率得到有代表性的样本。

下面将介绍如何选择恰当的样本。

抽样方法

简单随机抽样

简单随机抽样(simple random sampling):从总体N个单位中任意抽取n个单位作为样本,每个样本被抽中的概率相等。

- 无放回抽样(sampling with replacement):每个选中项立即从构成总体的所有对象集中删除

- 有会抽样 (sampling without replacement):对象被选中时不从总体中删除。在抽样过程中,每个对象被选中的概率保持不变。

分层抽样

当总体由不同类型的对象组成,每种类型的对象数量差别很大时,简单随机抽样不能充分地代表不太频繁出现的对象类型。当分析需要所有类型的代表时,这可能出现问题。因此需要提供具有不同频率的感兴趣的项的抽样方案。

分层抽样(stratified sampling):从预先指定的组开始抽样。有两种形式:(1)尽管每组的大小不同,但是从每组抽取的对象的个数相同。(2)从每组抽取的对象数量正比于该组的大小。

渐进抽样

合适的样本容量可能很难确定,因此有时需要使用自适应(adaptive)或渐进抽样(progressive sampling)方法。这些方法从一个小样本开始,然后增加样本容量直至得到足够容量的样本,尽管这种技术不需要在开始就确定正确的样本容量,但是需要评估样本的方法,确定它是否足够大。

例如,假定使用渐进抽样来学习一个预测模型。尽管预测模型的准确率随时间样本容量增加,

2.2.1 测量和数据收集问题

本文字数: 2.8k 阅读时长 ≈ 3 分钟

数据挖掘常常不能在源头控制质量,由于无法避免数据质量问题,因此数据挖掘着眼于两个方面:

- 数据质量问题的检测和纠正。

- 使用可以容忍低质量数据的算法。

其中第一步,检测和纠正,通常被称为数据清理。

下面将讨论数据质量的具体方面。

测量和数据收集问题

现实情况下期望数据是完美的并不现实。由于人为,测量设备限制等因素收集到的数据往往是有缺陷的。值甚至整个数据对象都可能丢失,也可能存在虚假或重复的对象。

本文将重点关注与数据测量和收集相关的数据质量问题。将从测量和数据收集错误的定义开始,然后考虑涉及测量误差的各种问题:噪声(noise)、伪像(artifacts)、偏倚(bias)、精度(precision)和准确率(accuracy)。最后,会讨论同时涉及测量和数据收集问题的数据质量问题:离群点、遗漏和不一致的值以及重复数据。